Come tutte le tecnologie, anche i moderni chatbot gestiti dall’Intelligenza Artificiale hanno avuto bisogno di un periodo di rodaggio. Inizialmente, infatti, si temeva che gli algoritmi generativi potessero diffondere tra gli utenti fake news, ipotesi corroborata da vari studi. Questi algoritmi, infatti, vengono addestrati nel mare magnum di internet e possono apprendere nozioni corrette come quelle sbagliate. Un recente studio condotto da un gruppo di studiosi del MIT di Boston, però, ha ribaltato questa prospettiva.

Impariamo dall’IA. Thomas Costello, a capo del progetto, ha mostrato in che modo i modelli linguistici che alimentano chatbot come ChatGPT, Gemini (prima nota come Google Bard) e Copilot (nata come Microsoft Bing AI) possono ridimensionare le convinzioni delle persone che credono nelle teorie del complotto, semplicemente discutendo con loro. Non solo, l’approccio che utilizzano ci suggerisce anche quale sia il modo migliore di interagire con i teorici della cospirazione, una tipologia di persona che mostra di avere una fede ostinata in ciò in cui crede.

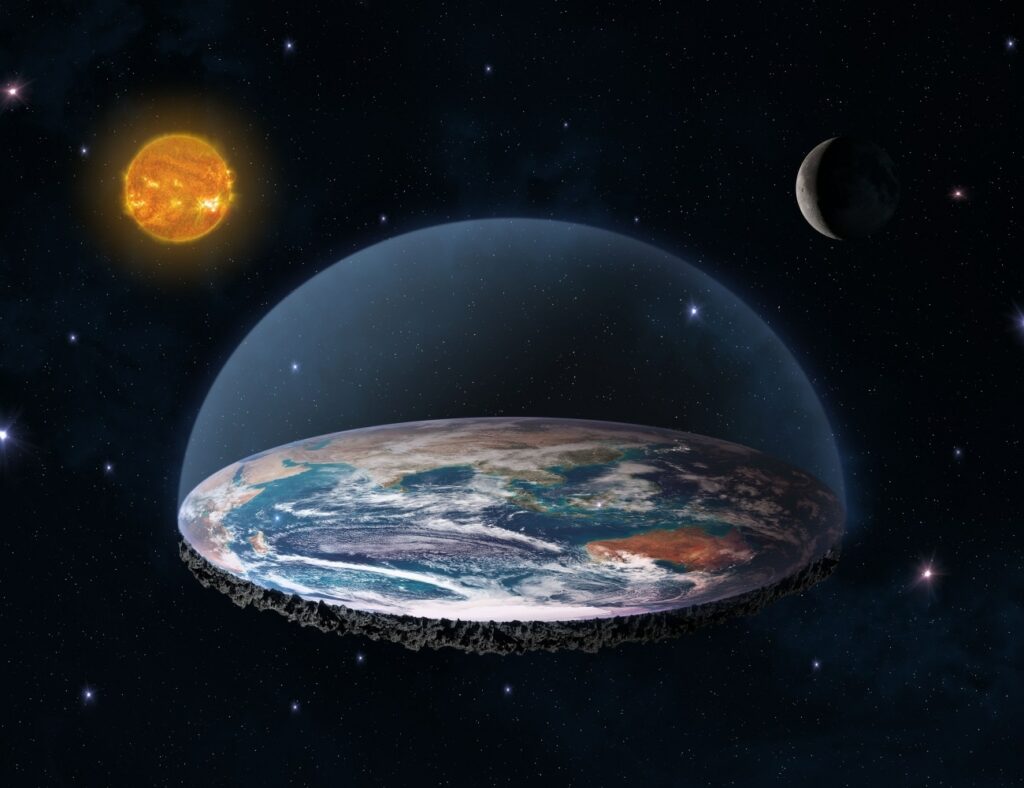

Teorie strampalate. Lo studio, pubblicato su PsyArXiv, ha coinvolto ben 2.190 seguaci delle teorie del complotto, dai “terrapiattisti” ai “lunaristi” (coloro che pensano che l’uomo non sia mai stato sulla Luna), passando per chi crede che tra noi si mimetizzino gli extra terrestri, che gli attentati dell’11 settembre 2001 siano stati orditi dal governo statunitense e che con i vaccini vengano iniettati dei microchip sottopelle al fine di controllare le menti.

Basta una “chattata”. L’esperimento si è svolto in più fasi; nella prima i partecipanti hanno illustrato in forma schematica una teoria, di cui erano convinti, all’ultima versione di ChatGPT (GPT-4 Turbo Large Language Model), che, a sua volta, ha generato un riassunto da sottoporre agli stessi. A questo punto, il chatbot ha iniziato una breve discussione con il diretto interessato, durata appena tre scambi di opinioni a testa, al termine della quale il “complottista” ha dovuto ripresentare per la seconda volta la sua teoria in forma schematica. Ebbene, nel 20% circa dei casi, gli esaminati hanno compreso dov’era lo sbaglio, cambiando il proprio parere.

Nessuna emotività. In effetti, l’IA è sembrata funzionare meglio di tanti esseri umani, facendo cambiare idea, in poche battute, a circa un partecipante su cinque. «Un approccio ampio e superficiale non funziona per persuadere i teorici del complotto, poiché tendono a studiare in maniera approfondita l’argomento in cui credono, anche se la loro comprensione potrebbe essere sbagliata», spiega Thomas Costello, a capo del progetto del MIT.

«I buoni risultati offerti dai chatbot potrebbero dipendere dal fatto che, invece di criticare, instaurano un dialogo sullo stesso livello, valendosi di argomenti persuasivi, concentrandosi sui fatti e non utilizzando né emotività né empatia».

Fotogallery Androidi, robot e simulacri: il bestiario del terzo millennio

Fonte Focus.it